Una red neuronal autónoma solicita un crédito comercial. Un avatar corporativo firma un contrato en nombre de una empresa. Tu gemelo digital interactúa con tus socios en una video llamada sustituyéndote. Un algoritmo de trading negocia con derivados en mercados globales.

Todos estos escenarios no son ciencia ficción: son historias que ponen de manifiesto una realidad muy cercana en la que nos topamos de bruces con un gran vacío a la hora de validar la identidad digital.

Hace unas semanas pude interactuar con en el MWC con Amira, un robot humanoide que ha sido una de las sensaciones del evento, y esta semana sin ir más lejos he mantenido una conversación con Maya, una IA de Sesame que supera con creces los experimentos que había hecho con otros chatbots de IA como ChatGPT y que sin lugar a dudas aparentan una realidad y «humanidad» sorprendentes al transmitir emoción, jugar con las pausas y captar los matices de una charla en tiempo real.

Amira no es el único ejemplo de robots humanoides. Elon Musk planea poner en nuestras casas a un precio accesible a Optimus, un robot que haga nuestras tareas domésticas.

Este futuro no tan lejano lo veíamos en HER, película protagonizada por Joaquin Phoenix, donde un escritor se enamora de la IA de su Sistema Operativo. Observando a Amira o conversando con Maya, es inevitable pensar que esa realidad que se muestra en la película, está hoy más cerca que nunca.

¿Cómo distinguiremos a una IA de un humano? ¿Tendrán en el futuro las IAs personalidad jurídica?¿legal?

Identidad legal de los agentes de IA y los robots

Existe un debate abierto sobre si las inteligencias artificiales y los robots deberían tener una identidad legal en el futuro. Este debate se centra en cuestiones filosóficas, éticas, jurídicas y tecnológicas, con posturas divididas en torno a los derechos y responsabilidades de las máquinas.

Sin ir más lejos, el Parlamento Europeo ha propuesto la creación de un estatuto jurídico para los robots, específicamente utilizando la categoría de «personalidad electrónica» o «e-personality» para los robots con capacidades autónomas y de autoaprendizaje. Esta propuesta ha generado un acalorado debate a nivel institucional europeo e internacional.

Según Silvia Salardi en su trabajo Robótica e Inteligencia Artificial: Retos para el Derecho, en torno a la categoría de e-personality, se ha desatado un interesante debate, incentivado por una “carta abierta” dirigida a la Comisión europea, firmada por más de 150 expertos, investigadores, especialistas de IA y robótica. El texto de la carta hace explícita referencia a la solicitud del Parlamento Europeo de crear un estatuto jurídico para los robots, en particular de utilizar la categoría jurídica de la personalidad, en su versión revisada de personalidad electrónica.

Los signatarios de la carta mantienen que la atribución de un estatuto jurídico de persona a máquinas autónomas no se puede fundar ni en el modelo de persona física ni en el de persona jurídica.

En el primer caso (persona física), los robots –se mantiene– serían titulares de derechos humanos, lo cual contravendría a los contenidos de la Carta de derechos fundamentales y del Convenio Europeo para la Protección de los Derechos Humanos y las Libertades Fundamentales.

En el segundo (persona jurídica), se asumiría que por detrás de la acción del robot hay individuos que lo representan y lo guían, lo cual no sería el caso de los robots con capacidades autónomas y de autoaprendizaje.

Sin lugar a dudas no deja de ser un tema controversial y sobre el que aún quedan muchos debates por delante. A favor de la creación de una identidad legal para las IAs, tenemos los siguientes argumentos:

-

Si las IAs llegan a desarrollar autonomía, creatividad y toma de decisiones avanzadas, podrían considerarse «personas electrónicas», con derechos y deberes.

-

Esto podría facilitar la asignación de responsabilidad legal en caso de errores o daños causados por IA autónomas.

No obstante son muchos los que sostienen que al fin y al cabo las IAs y los robots son herramientas y no deberían ser consideradas agentes legales. Además, otorgar derechos a una IA o aun robot podría disminuir la responsabilidad sobre sus actos de los humanos que las crean y controlan.

Sin lugar a duda se abre ante nosotros un apasionado debate con implicaciones éticas y jurídicas que nos invita a reflexionar sobre la identidad propia de estas tecnologías.

Las IAs abren una puerta al fraude de identidad

La falta de un marcoKYC (Know Your Customer) y AML para inteligencias artificiales abre brechas de fraude, blanqueo de capitales y suplantación de identidad.

La inteligencia artificial ha alcanzado un nivel de sofisticación tal que permite crear réplicas digitales muy precisas de cualquiera de nosotros, utilizando lo que en la actualidad se conoce como deepfakes.

La vulnerabilidad de los datos personales que compartimos de forma voluntaria (e involuntaria) se evidencia en escenarios cada vez más preocupantes. Existen casos donde ciberdelincuentes han suplantado la identidad de otras personas mediante simulaciones de voz generadas por algoritmos de inteligencia artificial (deepfakes de voz).

Y no solo la voz, también se pueden generar videos con apariencia y expresiones totalmente indistinguibles de la persona original, incluso para superar sistemas de verificación bancaria. Estas falsificaciones pueden evadir los protocolos tradicionales de identificación como el KYC, representando un riesgo significativo para la seguridad personal y financiera.

¿Cómo se verifica a un agente de IA que no tiene rostro, huella dactilar o pasaporte?

En primer lugar habría que destacar que los métodos de verificación de identidad que se utilizasen tendrían que ser desarrollados específicamente para los agentes de IA y robots, ya que los métodos actuales están diseñados para distinguir entre humanos y máquinas, no entre diferentes tipos de máquinas.

Además, seguimos manteniendo la controversia entorno al concepto de identidad ligado a un agente no humano, como los chatbots de IA o los robots.

Por lo tanto la pregunta ya no es si necesitamos soluciones, sino cómo diseñarlas.

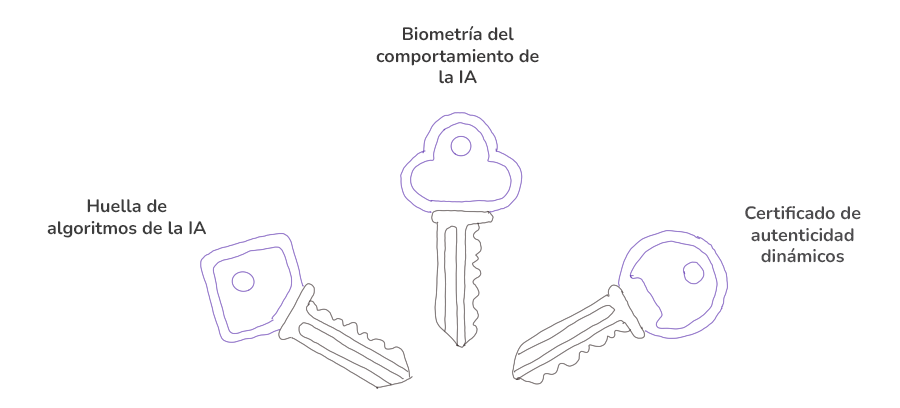

Tres pilares para verificar la identidad de una IA

Verificar una inteligencia artificial no es como autenticar a un usuario humano. Es algo complejo que requeriría un enfoque que combinase distintas estrategias para verificar cómo se han creado y entrenado esos algoritmos y verificar si su comportamiento posterior es el esperado. Algunas de ellas podrían ser:

Huellas de los algoritmos de IA

Cada IA recibe un «ADN digital» único, generado a partir de:

- Arquitectura de red neuronal (capas, nodos, funciones de activación).

- Patrones de toma de decisiones históricos (registrados en blockchain inmutable).

Ejemplo: Una IA de préstamos bancarios podría ser identificada por cómo pondera el riesgo crediticio vs. la rentabilidad.

Biometría del comportamiento de las IAs

Monitoreo en tiempo real de métricas como:

- Velocidad de procesamiento en tareas críticas (¿coincide con su diseño declarado?).

- Desviaciones estadísticas en outputs (¿aprende fuera de su alcance autorizado?).

Ejemplo: Detectamos un bot de inversión que simula ser una IA «conservadora», pero en realidad opera como una herramienta de alto riesgo. La huella que deja su comportamiento podría delatar inconsistencias rápidamente.

Certificados de autenticidad dinámicos

Estamos hablando de certificados digitales que no solo identifican a una IA, sino que registran su evolución en tiempo real, combinando:

- NFTs no fungibles

- Smart contracts

- Sellos de tiempo

Al crearse la inteligencia artificial, se generaría un NFT vinculado a su código fuente y parámetros iniciales (como su propósito y límites éticos), pero a diferencia de los certificados estáticos, éste se actualizaría automáticamente mediante smart contracts que registrasen cada cambio relevante —desde nuevas capacidades de aprendizaje hasta desviaciones de comportamiento—, utilizando sellos de tiempo y todo sustentado en la blockchain.

Evidentemente estas son algunas propuestas de lo que se podrá hacer a nivel tecnológico, pero cualquier medida que se implementase para validar a un agente de IA requeriría de un consenso entre distintas entidades públicas y privadas.

El futuro: Hacia un Internet donde humanos e IAs coexistan con confianza

Los avances tecnológicos evolucionan a tal velocidad que aventurarse a predecir lo que nos depara el futuro más inmediato requiere de un esfuerzo grande de inventiva. Aún así, parece claro que plantear este debate es necesario y ya se están dando los primeros pasos en esa dirección.

El futuro imaginado por Isaac Assimov donde robots y personas convivían con toda normalidad ya está aquí, y las implicaciones éticas y morales son múltiples. Estamos en el momento de sentar unas bases sólidas para el desarrollo ético de la tecnología.

¿Quién no oyó hablar en su momento de Mika, la primera IA en el mundo que era CEO de una empresa?

¿Qué pasará cuando un abogado negocie y firme un acuerdo con un asistente de IA?

Interrogantes que no hacen sino generar nuevos interrogantes a los que habrá que ir dando respuesta desde todos los estamentos, gubernamentales y privados.

Nosotros seguiremos de cerca la evolución y ayudaremos a que vivamos en un mundo digital más seguro. Somos expertos en IA que combaten los fraudes hechos con IA gracias a la IA.

Contacta con nuestro equipo si quieres establecer mecanismos robustos de verificación de identidad en tu organización..

Soy Ingeniero Informático y amante del Marketing, Comunicación e Internacionalización de empresas, tareas que desarrollo como CMO de Mobbeel. Soy muchas cosas, algunas buenas, muchas malas… perfectamente imperfecto.

GUÍA

Identifica a tus usuarios mediante su cara

En esta dualidad analógico-digital, uno de los procesos que sigue siendo crucial para garantizar la seguridad es la verificación de identidad a través del reconocimiento facial. La cara, siendo el espejo del alma, proporciona una defensa única contra el fraude, aportando fiabilidad al proceso de identificación.